Алгоритмы в цифровой рекламе давно перестали быть просто инструментами оптимизации. Они принимают решения о том, кто увидит вашу рекламу, а кто останется за бортом. И часто эти решения оказываются дискриминационными — даже если вы этого не планировали.

Современные рекламные платформы дают ощущение точности: можно выбрать нужную аудиторию, исключить лишних и оптимизировать расходы до клика. Но под этим удобством скрываются зоны, где таргетинг пересекает неэтичные, а иногда и незаконные границы.

Дискриминация в рекламе происходит не только через прямой выбор признаков вроде возраста или пола. Даже если рекламодатель не хочет нарушать правила, за него это может сделать алгоритм. И тогда кампания, настроенная на «эффективность», начинает незаметно исключать группы людей по признакам, защищенным законом.

В статье разберем механизмы алгоритмической дискриминации, покажем реальные примеры и дадим практические рекомендации, как избежать нарушений закона и репутационных рисков. Материал будет полезен маркетологам, юристам и всем, кто работает с цифровой рекламой.

Маркетинг больше не нейтрален

Рекламные инструменты больше не просто показывают объявления. Они принимают решения. А значит, влияют на то, кто получит доступ к кредиту, вакансии или медицинской информации. И здесь уже нельзя полагаться только на эффективность или автоматизацию.

Когда платформа предлагает исключить пользователей с определенным доходом или интересами, это может выглядеть как оптимизация. Но если под этими интересами скрываются признаки болезни, психического состояния или сексуальной ориентации — это уже риск нарушения закона. В некоторых случаях такие действия квалифицируются как дискриминация, даже если рекламодатель об этом не знает.

Специалисты по прокси-дискриминации в сфере здравоохранения выяснили: алгоритмы могут выделять пользователей с определенными диагнозами, опираясь на косвенные данные. Под анализ попадают поведение в приложениях, запросы в интернете, тип страховки. Это особенно опасно в нишах, где от рекламы зависит доступ к важной информации — например, о здоровье или финансах.

Неочевидные признаки, которые приводят к исключению

Возраст, семейное положение, уровень образования — все это кажется безобидными параметрами, пока не начинаешь изучать, как они влияют на итоговую выборку аудитории.

Модели кредитного скоринга, построенные на этих признаках, часто исключают целые группы пользователей. Это происходит даже если сами по себе параметры не запрещены. Одинокий молодой человек с высшим образованием может получить отказ по займу просто потому, что его профиль похож на тех, кто раньше не возвращал долги.

В рекламе происходит то же самое. Алгоритм может «оптимизировать» показ вакансии, исключая женщин младше 30, если по статистике они реже откликаются. Или сужать аудиторию, оставляя только пользователей с определенным уровнем образования. И это может не иметь никакого отношения к содержанию предложения. Все это — признаки серых зон, где маркетолог рискует нарушить закон, даже не подозревая об этом.

Где закон смотрит особенно внимательно

Не все отрасли подвержены одинаковым рискам. Внимание регуляторов сосредоточено на тех сферах, где последствия дискриминации наиболее критичны: здравоохранение, финансы, трудоустройство.

В медицине недопустимо даже намекать в рекламных сообщениях на диагноз или состояние пользователя. Любая попытка сегментации по косвенным признакам может быть расценена как вторжение в личную жизнь. Платформы вроде Meta уже не позволяют напрямую таргетировать по интересам, связанным с болезнями. Но алгоритмы все еще могут выводить такие аудитории за счет машинного обучения.

В трудоустройстве особенно жестко регулируется показ вакансий. Работодателю запрещено ограничивать аудиторию по возрасту, полу, расе или семейному положению. Но даже при отсутствии прямых ограничений алгоритм доставки рекламы может сам отсеивать женщин или пожилых кандидатов. Он ориентируется на прошлое поведение пользователей. Такие искажения возникают регулярно — особенно на платформах, где таргет работает по поведенческим шаблонам.

В финансовой сфере под запретом использование даже косвенных индикаторов, которые могут указывать на расу или этническую принадлежность. Некоторые штаты США уже ввели запрет на применение прокси-переменных при принятии решений о займах и страховании. Это означает, что даже «нейтральная» переменная может считаться незаконной, если она приводит к неравному результату.

Когда алгоритм подражает предвзятости

Алгоритмы, обученные на реальных данных, не становятся объективными. Напротив, они перенимают предвзятости и ошибки, заложенные в прошлом.

Система, оптимизирующая рекламу по кликам, начинает отдавать предпочтение тем, кто кликает чаще. В результате объявления о высокооплачиваемой работе чаще видят мужчины, а реклама бюджетных товаров — жители бедных районов. Платформа не знает, кого она исключает, но результат говорит сам за себя.

Команда Northeastern University провела анализ автоматических кампаний. Выяснилось: вакансии бухгалтеров чаще показывались женщинам, а руководителей — мужчинам, даже при одинаковом бюджете. Такие искажения не задумывались рекламодателем. Они происходят, потому что алгоритм ориентируется на прошлое, а не на справедливость. Аналитики McKinsey формулируют это так: «Справедливость — не свойство системы, а результат управления и контроля».

Нейтральные параметры, которые ведут к дискриминации

Даже если вы не используете чувствительные признаки напрямую, можно неосознанно воспроизвести дискриминацию через косвенные характеристики. Это называется прокси-дискриминацией.

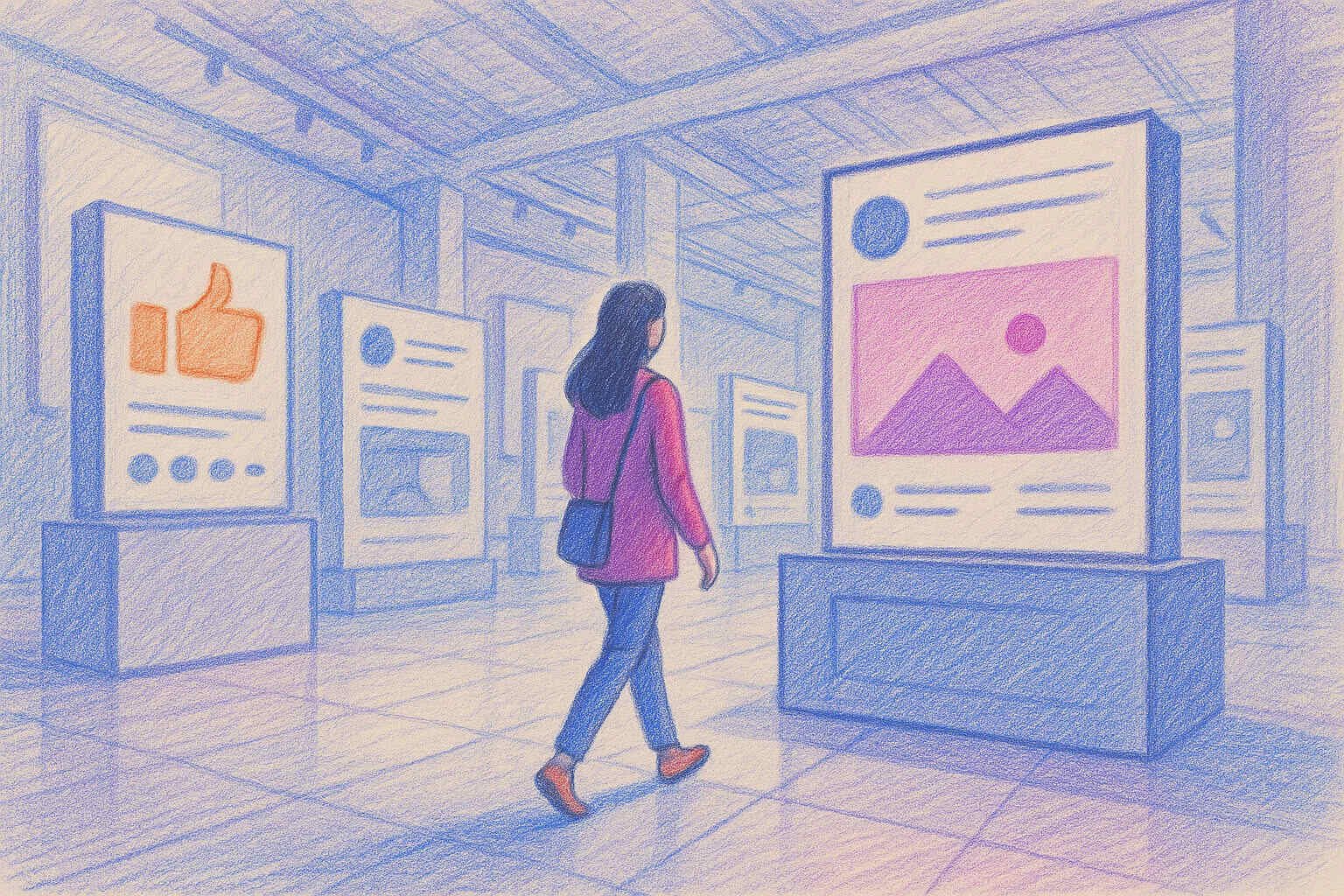

Рекламодатель может задать геолокацию, интерес к определенной теме, тип устройства — и в итоге получить аудиторию, полностью состоящую из одной этнической группы или социального слоя. Анализ распределения рекламных показов на Meta обнаружил закономерность: даже при равных настройках система сама решает, кому что показывать. Объявления о кредитах чаще доходят до белых пользователей, а реклама аренды — до черных и латиноамериканцев. Не потому что так захотел маркетолог, а потому что так работает алгоритм доставки.

Это особенно опасно в чувствительных категориях: жилье, занятость, кредиты. Там любой перекос может быть признан дискриминацией — даже если формально правила платформы не нарушены.

Регулирование алгоритмической дискриминации

С 2024 года в Европейском союзе действует AI Act — первый в мире комплексный закон об искусственном интеллекте. Закон устанавливает обязательные требования к системам ИИ высокого риска, включая те, что используются в рекламе. С февраля 2025 года вступили в силу запреты на дискриминационные практики ИИ.

В США Министерство юстиции в 2022 году заключило соглашение с Meta о создании новой системы Variance Reduction System (VRS). Она должна предотвращать дискриминацию в рекламе жилья. Система должна обеспечивать равное распределение рекламы между различными демографическими группами.

Правозащитная организация Global Witness выяснила: алгоритмы Meta по-прежнему дискриминируют по гендерному признаку при показе вакансий, несмотря на принятые меры. Компания развернула новую ИИ-систему для борьбы с алгоритмической предвзятостью. Но эксперты AlgorithmWatch считают это скорее «пластырем», чем реальным решением проблемы.

Как минимизировать риски

Чтобы рекламные кампании не нарушали закон и не отсеивали аудиторию по недопустимым признакам:

- Регулярно проверяйте, кому действительно показываются объявления, особенно в автоматических кампаниях.

- Избегайте настройки по признакам, которые могут служить косвенными маркерами чувствительных категорий.

- Изучайте ограничения в своей отрасли: для медицины, финансов и рекрутинга действуют отдельные правила.

- Следите за изменениями в регулировании ИИ в юрисдикциях, где работает ваша компания.

Ответственность как новая эффективность

Цифровая реклама — мощный инструмент, но он не нейтрален. Она может усиливать старые неравенства, даже если этого никто не планировал. Поэтому сегодня эффективность — это не только про клики и охваты. Это еще и про ответственность за то, кто видит вашу рекламу. Или, что важнее — кто ее не видит.

Резюмируя можно выделить основные идеи:

Алгоритмическая дискриминация — это реальность. Даже при корректных настройках таргетинга системы доставки рекламы могут самостоятельно создавать перекосы по демографическим признакам. Это происходит потому, что алгоритмы оптимизируют под историческое поведение пользователей, воспроизводя социальные предрассудки.

Регулирование ужесточается. AI Act в ЕС и судебные решения в США показывают: эпоха саморегулирования заканчивается. Компании будут нести прямую ответственность за справедливость своих алгоритмов, а не только за соблюдение формальных требований.

Проблема касается всех отраслей. Хотя пристальное внимание регуляторов пока сосредоточено на жилье, трудоустройстве и финансах, принципы алгоритмической справедливости распространяются и на другие сферы. Особенно это актуально для компаний, работающих с социально значимыми услугами.

Прогноз на ближайшее время:

2025-2026 годы станут переломными для индустрии цифровой рекламы. Мы ожидаем:

- Усиление аудитов алгоритмов. Регуляторы будут требовать от платформ регулярные отчеты о справедливости распределения рекламы.

- Появление новых инструментов мониторинга. Рекламодатели получат больше данных о том, кому реально показывается их реклама.

- Рост штрафов и судебных исков. Нарушения алгоритмической справедливости будут караться жестче — вплоть до 35 млн евро или 7% оборота.

- Изменение бизнес-моделей платформ. Рекламные системы будут перестраиваться с фокуса на эффективность на баланс эффективности и справедливости.

Компании, которые начнут адаптироваться к новым требованиям уже сейчас, получат конкурентное преимущество. Те, кто будет ждать принуждения, рискуют столкнуться с серьезными правовыми и репутационными последствиями.

Будущее цифровой рекламы — за алгоритмами, которые не только эффективны, но и справедливы. И это будущее наступает быстрее, чем многие ожидают.