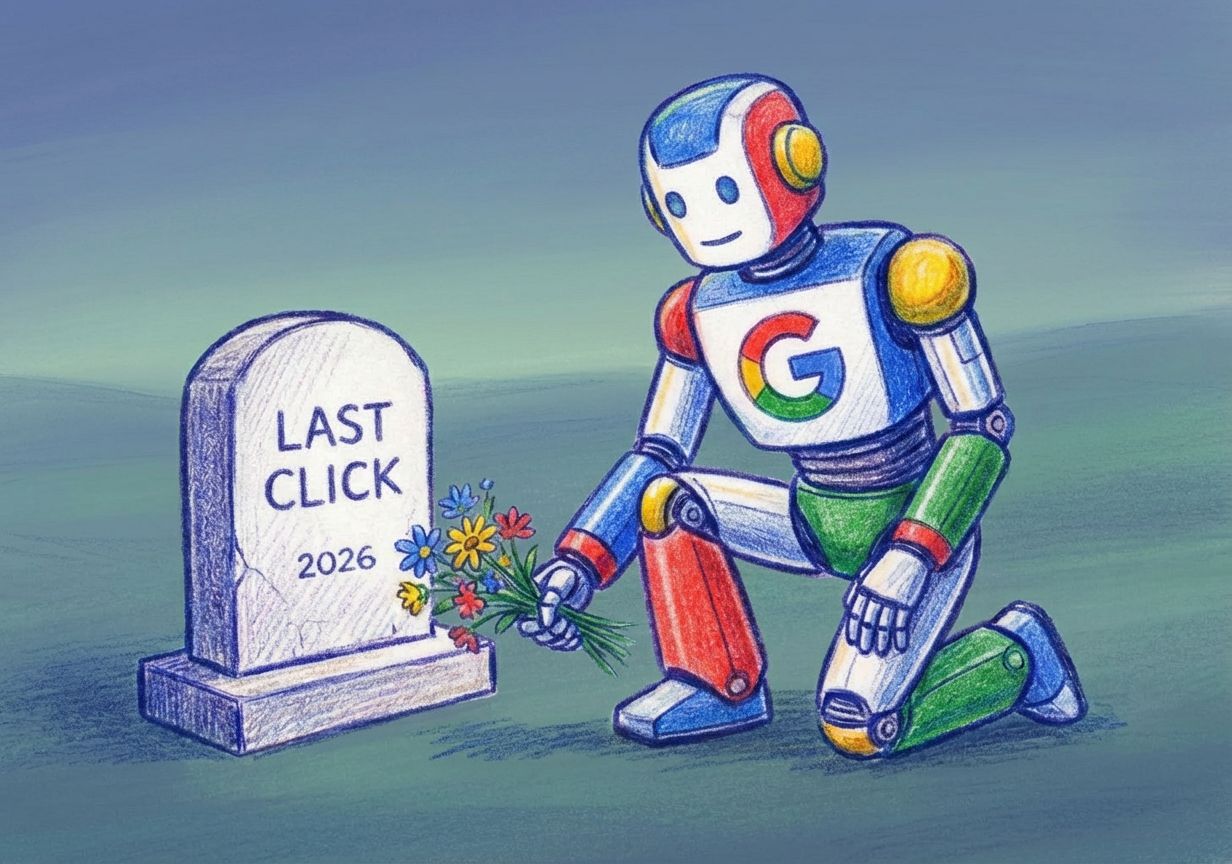

Google убрал поддержку &num=100 из поисковой выдачи. Этот параметр позволял SEO-инструментам (Ahrefs, Semrush, SerpApi и пр.) запрашивать сразу по 100 результатов на страницу, чтобы отслеживать позиции, CTR и ранжирование. Теперь выдача ограничена 10–20 ссылками. Попытка принудительно расширить список игнорируется.

Плохо всем

На первый взгляд это боль SEO-инструментов. На деле — удар по всей экосистеме данных, измерения и performance-аналитики:

- Методы трекинга позиций (особенно у performance-платформ, которые использовали модели видимости organic+paid) рушатся.

- Сложнее «сшивать» поисковую видимость и платную выдачу — ведь трекеры часто использовали эти API для построения стратегий контентного продвижения, офферов и белых лендингов.

- Вся система быстрой обратной связи в SEO становится медленнее, а значит, эффективность оптимизаций падает.

Таргет вслепую

Точность трекеров позиций резко упадет, особенно для низкочастотных запросов и страниц, находящихся за пределами ТОП-20. Теперь они будут показывать вам не реальную позицию, а «вероятную», основанную на усеченной выборке.

Принимать серьезные решения на основе этих данных становится опасно и дорого: чем меньше вводных данных, тем выше цена входа, оптимизации и трафика. Rank-tracking сервисы смогут выжить только за счет обходных путей.

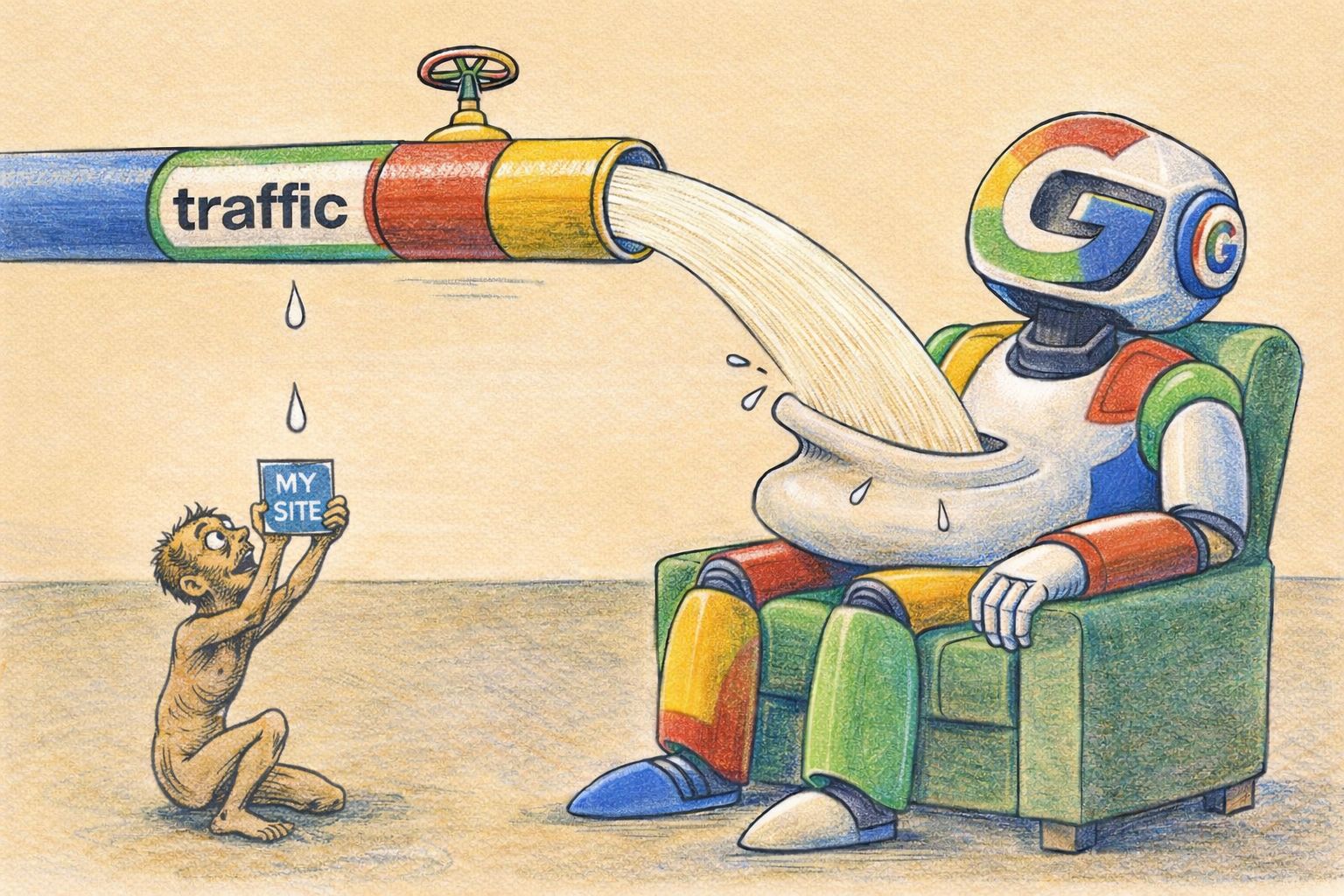

Слепнут не только трекеры, но и тесты. Google забирает себе монополию на интерпретацию данных своего поиска, отрезая независимые метрики. Это заставляет еще сильнее полагаться на гугловские инструменты вроде Search Console (который вместе с Performance Max подозрительно вовремя начал пушиться). Все идет к тому, что через год Google окончательно замкнет аналитическую экосистему на своих API.

Как жить в апокалипсисе

Вся методология, построенная на анализе тысяч SERP-страниц для сбора E-E-A-T-сигналов, анализа конкурентов и выявления паттернов, летит в тартарары. Теперь нельзя просто так взять и получить полную картину по любому запросу. Это выгодно крупным игрокам, у которых есть деньги на дорогие API и собственные нейросети для анализа, но бьет по мелким и средним командам.

Дальше вероятен сдвиг в сторону «умного» SEO. Если ранее можно было выехать на техническом анализе и массовом сборе данных, теперь фокус смещается на:

- Глубокий анализ пользовательского опыта (UX)

- Создание контента, который алгоритм сочтет безупречным, а не который просто соответствует формальным критериям

- Работу с брендом и цитируемостью, а не с ключевыми словами.

Надо готовиться к тому, что SEO-платформы пересчитают модели. Performance-аналитика, завязанная на organic+paid видимости, даст расхождение в отчетах. Но мы прорвемся.